وقتی حقیقت در عمق دروغ غرق میشود!

به گزارش شبکه خبری ICTPRESS ، این فناوری از سال ۲۰۱۷ و با اقدام یک کاربر که از آن برای تغییر چهره افراد مشهور و قرار دادن آنها در فیلمهای غیراخلاقی استفاده کرده بود، بر سر زبانها افتاد.

با گسترش استفاده از "دیپفیک"، متخصصان حوزه فناوری، در مورد پیامدهای منفی احتمالی آن هشدار داده و بر لزوم احتیاط در مورد آن تاکید میکنند.

ساخت ویدئوهای دیپفیک

ویدئوهای "دیپفیک"، با استفاده از دو سیستم مبتنی بر هوش مصنوعی ساخته میشوند که "تولیدکننده"(generator) و "تفکیککننده"(discriminator) نام دارند. در فرآیند تولید ویدئوی دیپفیک، تولیدکننده، یک ویدئوی غیرواقعی را تولید میکند و سپس تفکیککننده، واقعی یا غیرواقعی بودن آن را تشخیص میدهد. هر بار که تفکیککننده، ویدئویی را غیرواقعی تشخیص دهد، سرنخی به تولیدکننده ارائه میکند، تا نکات در ساخت ویدئوی بعدی رعایت شوند.

تولیدکننده و تفکیک کننده به همراه یکدیگر، یک "شبکه مخالف مولد"(GAN) را شکل میدهند. نخستین گام برای شکلگیری یک شبکه مخالف مولد، شناسایی خروجی مورد نظر و ایجاد یک مجموعه داده آموزشی برای تولید کننده است. هنگامی که تولیدکننده بتواند سطح قابل قبولی از خروجی را ایجاد کند، امکان انتقال ویدئوها به تفکیک کننده فراهم میشود.

همزمان با افزایش مهارت تولیدکننده در ایجاد ویدئوهای تقلبی، تفکیککننده نیز در بررسی آنها مهارت پیدا میکند. متقابلا هر قدر تفکیککننده در بررسی مهارت یابد، تولیدکننده نیز در ایجاد ویدئو ماهر میشود.

تغییر محتوای ویدئوها تا به امروز، کار بسیار دشواری بوده است اما از آنجا که ویدئوهای "دیپفیک" با کمک هوش مصنوعی تولید میشوند، به مهارت قابل توجهی که برای تولید یک ویدئوی واقعی به کار میرود، نیازی ندارند.

ابزاری در دست سودجویان

نکته منفی در مورد ویدئوهای دیپ فیک این است که هر کسی میتواند به تولید آن بپردازد؛ در نتیجه همیشه امکان سوءاستفاده از چنین ویدئوهایی وجود دارد و نمیتوان به سادگی به محتوای آنها اعتماد کرد. در واقع، میتوان گفت که اگرچه دیپ فیک، یک فناوری کارآمد با ویژگیهای مثبت به نظر میرسد اما میتواند پیامدهای منفی بسیاری را در حوزههای گوناگون از فناوری گرفته تا سیاست به همراه داشته باشد.

اگر دیپفیک در دست افراد سودجو قرار گیرد، امکان رخ دادن هر پیامد منفی وجود خوهد داشت. برای مثال، چنین افرادی به سادگی میتوانند از این ابزار برای تخریب نام شرکتهای بزرگ استفاده کنند یا در حوزه سیاست، به راحتی میتوان دیپ فیک را برای از بین بردن محبوبیت یک شخصیت سیاسی به کار گرفت و تصویری کاملا غیرواقعی از وی به نمایش گذاشت. بدین ترتیب، دیپفیک به راحتی می تواند یک نام آشنا و مشهور را در حوزه تجارت، فناوری یا سیاست از بین ببرد.

مصاحبههای صورت گرفته با متخصصان فعال در حوزه فناوری، اهمیت رعایت اخلاقیات را در مورد پژوهشهای هوش مصنوعی نشان میدهند. متخصصان باور دارند که خطرات گوناگون این حوزه از جمله آسیبهای امنیتی باید به دقت شناخته شوند و موسسات فعال در حوزه فناوری، نسبت به آموزش نیروها اقدام کنند تا بتوانند به سادگی از عهده مقابله با خطرات دیپفیک برآیند.

در هر حال، مقابله با دیپفیک، کار سادهای نخواهد بود. اگرچه ابزارهایی برای شناسایی با دیپفیک ابداع شده و یا در حال ارائه هستند اما دیپفیک، فناوری قدرتمندی است و مقابله با آن، به یک فرآیند بررسی طولانی نیاز دارد.

نگرانی متخصصان در مورد دیپفیک، دلایل گوناگونی دارد. ابزار تولید ویدئو که از کیفیت بالایی نیز برخوردار هستند، بیش از پیش در اختیار جامعه قرار دارند. جوامع کنونی میتوانند اطلاعات را به سرعت دریافت و منتقل کنند اما هیچ کس برای تشخیص ویدئوهای ساخته شده با دیپفیک آموزش ندیده است. هنگامی که یک متن تغییر یافته را میخوانیم، میتوانیم با بررسی مفهوم، علائم نگارشی و کلمات به تغییر آن پی ببریم اما تشخیص محتوای یک ویدئوی تغییر یافته با دیپفیک، کار سادهای نیست.

ویدئوهای دیپفیک که تولید آنها در سال ۲۰۱۷ صورت میگرفت، به دانش بالایی در زمینه علوم رایانه، رایانههای بسیار قوی و داده های گسترده نیاز داشتند اما در حال حاضر، هر کس میتواند با یک رایانه که قدرت کافی برای کار کردن با این فناوری را دارد، به تنظیم ابزار دیپفیک بپردازد و ویدئوی مورد نظر خود را تولید کند.

مهمترین نکته برای تشخیص ویدئوهای دیپ فیک، زمان است. زمان میتواند به کسب مهارت کافی برای تشخیص بهتر ویدئوها کمک کند. همانگونه که فتوشاپ در آغاز کار، به این اندازه شناخته شده نبود و کاربرد نداشت، دیپفیک نیز به مرور زمان، مراحل تکامل را طی خواهد کرد و به همین میزان، درک متخصصان در مورد این فناوری و نحوه تشخیص ویدئوهای تولید شده با آن نیز بهبود خواهد یافت.

پروفسور "رابرت فوئل"(Robert Foehl)، استاد دانشگاه اوهایو گفت: حتی اگر تشخیص ویدئوهای غیر واقعی از ویدئوهای واقعی ممکن شود، آسیبهای آن در زمینه اخلاقی و انسانی به قوت خود باقی خواهند ماند. بزرگترین خطر ویدئوهای تولید شده با دیپفیک، این است که کاملا تشخیص ناپذیر هستند؛ در نتیجه جامعه نمیتواند به سادگی به آنها اطمینان کند و تردید افراد جامعه در مورد آنها از بین نمیرود.

فناوری کارآمد

اگرچه به موارد بسیاری از جنبههای منفی دیپفیک اشاره شد اما این فناوری، از کاربردهای مثبت هم خالی نیست. یکی از این نمونههای مثبت، ویدئویی بود که دیوید بکام را در حال آگاه کردن مردم درباره بیماری مالاریا و نحوه محافظت در برابر این بیماری نشان میداد. در این ویدئو، از ۹ زبان گوناگون استفاده شد تا پیام مورد نظر، در سطح گستردهتری منتقل شود. چنین ویدئویی، هم کارایی مفیدی برای جامعه است و هم دستاورد مثبتی برای افراد مشهور حاضر در ویدئو به شمار میرود.

از دیپفیک میتوان برای بهبود سیستم آموزشی نیز استفاده کرد. تصور کنید که دانشآموزان درکلاس فیزیک، انیشتین را در مقابل خود ببینند که نظریه نسبیت را برای آنها توضیح میدهد. چنین کاری، به درک بهتر درس، خلاقیت دانشآموزان و نشاط کلاس کمک بزرگی خواهد کرد.

دیپفیک میتواند در حوزه تجارت و بازار نیز ابزار کارآمدی باشد و برای آموزش کارمندان و حتی کمک به مشتریان به کار رود. شرکتها و فروشگاهها میتوانند از چهره افراد مشهور برای معرفی محصول خود به مشتریان استفاده کنند.

در حوزه رسانه نیز میتوان از دیپفیک برای اصلاح ویدئوی مصاحبهها استفاده کرد. بدین ترتیب، اصحاب رسانه در مورد بروز اشتباهات احتمالی در مصاحبهها نگران نخواهند بود و در صورت لزوم میتوانند آنها را به سادگی و با سرعت اصلاح کنند.

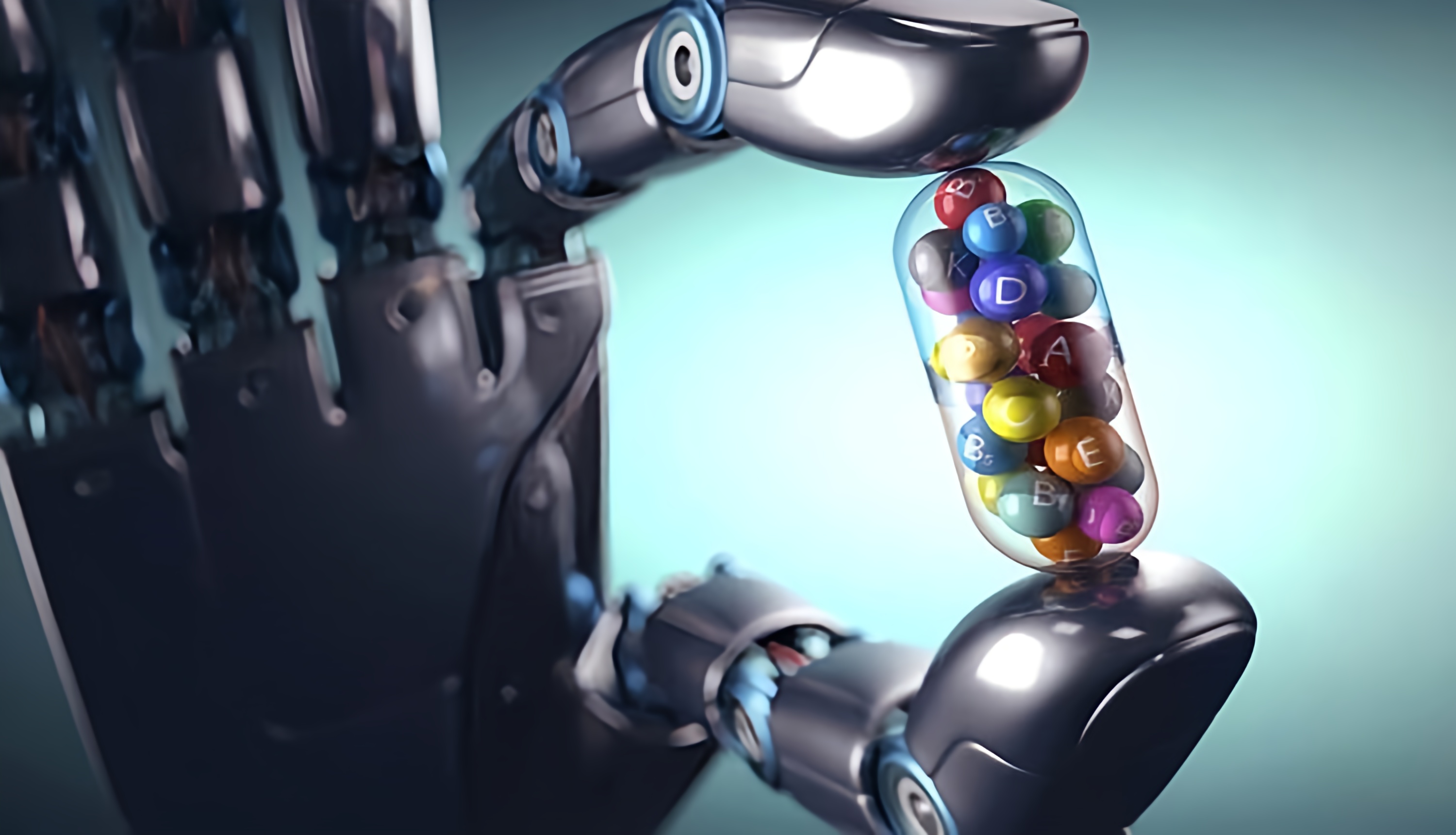

دیپفیک میتواند در پزشکی نیز حضور موثری داشته باشد. بیماران مبتلا به مشکلاتی مانند "اسکلروز جانبی آمیلوتروفیک" (ALS) که قادر به صحبت کردن نیستند، میتوانند ویدئوهایی از خود را در حال صحبت کردن ببینند و امید بیشتری به ادامه درمان پیدا کنند. افرادی که در اثر بروز مشکلاتی مانند سکته، قدرت سخن گفتن و برقراری ارتباط را از دست دادهاند نیز میتوانند از مزایای دیپفیک بهرهمند شوند. در هر حال، به کار بردن دیپفیک در این زمینه باید با رعایت کامل اصول اخلاقی و قانونی صورت بگیرد تا موجب آسیب رسیدن به بیمار نشود.

دیپفیک در کمین امنیت سایبری

امنیت سایبری، قطعا یکی از حوزههایی است که در معرض تهدید دیپفیک قرار دارد. فناوری هوش مصنوعی که در توانایی فعالیت دیپفیک نقش دارد، به شکلگیری حملات بزرگ سایبری نیز کمک خواهد کرد. شاید یکی از مهمترین دلایل بروز این خطرات، پیشرفت شبکههای مخالف مولد و کاهش موانع استفاده از هوش مصنوعی باشد.

سازمانها باید برای پیشگیری از بروز چنین حملاتی، بررسیهای گستردهای برای محافظت از شبکهها انجام دهند و جنبههای اخلاقی لازم را ارائه کنند تا بتوانند از عهده محافظت از اطلاعات مهم و محرمانه برآیند.

مهار خطرات دیپفیک

خطر اصلی دیپفیک این است که میتواند به درک نادرست ختم شود و هر شکلی به خود بگیرد؛ در نتیجه متخصصان این حوزه باید توانایی تشخیص خود را بهبود ببخشند تا بتوانند از خطرات آن در امان بمانند. شرکتها باید نکاتی که در مورد آنها و کارمندانشان در اینترنت منتشر میشوند، بررسی کنند. شبکهها و وبسایتها در حال حاضر، محتوای منتشر شده را کنترل میکنند؛ در نتیجه شرکتها میتوانند این محتوا را شناسایی، بررسی و درصورت لزوم حذف کنند. در هر حال، حتی با این روش هم تشخیص دیپفیک دشوار خواهد بود و روش سادهای برای تشخیص آن وجود نخواهد داشت. به علاوه، این کار، به تحلیلگرانی نیاز دارد که محتوا را مورد ارزیابی دقیق قرار دهند.

نظرات : 0